Ricerca rivoluzionaria nel campo della tecnologia delle comunicazioni ottiche da parte di Ibm. I ricercatori hanno sperimentato un nuovo processo per l’ottica co-packaged (Cpo), la tecnologia ottica di prossima generazione, che permetterà di connettere i data center alla velocità della luce tramite componenti ottici a complemento degli attuali cavi elettrici a corto raggio. In pratica, la nuova tecnologia potrebbe migliorare drasticamente il modo in cui i data center addestrano ed eseguono i modelli di AI generativa.

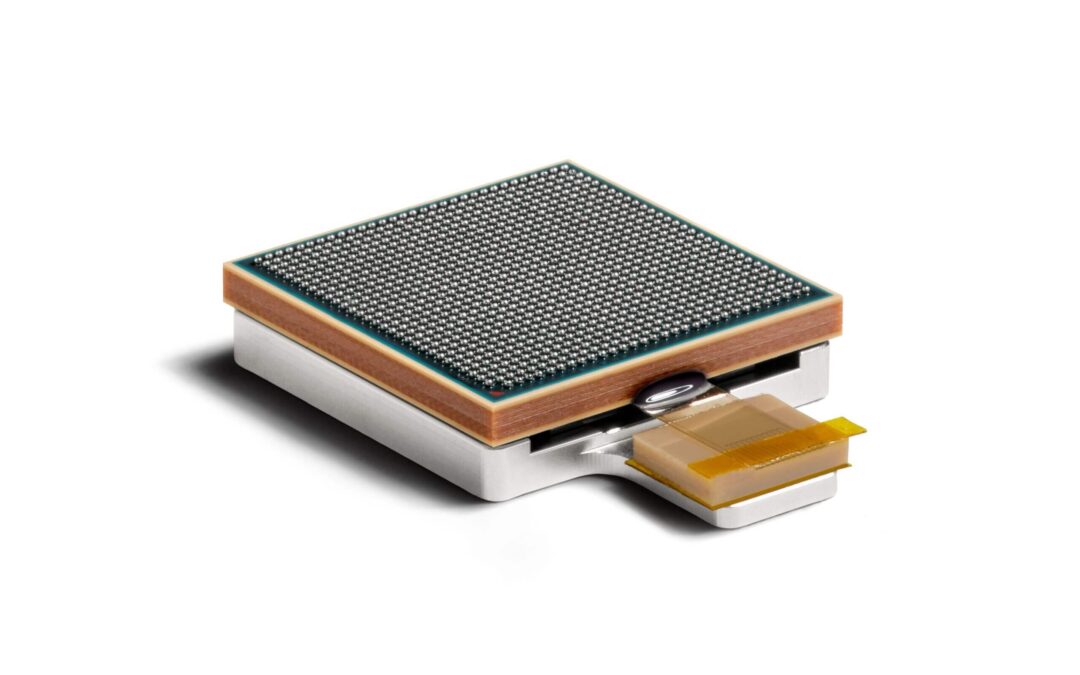

Avendo progettato e assemblato il primo esempio funzionante di guida d’onda ottica in polimero (Pwg), i ricercatori Ibm hanno dimostrato come la tecnologia Cpo ridefinirà il modo in cui l’industria informatica trasmetterà dati tra chip, schede di circuiti e server con un’elevata larghezza di banda.

La tecnologia attuale

Oggi, la tecnologia in fibra ottica trasporta i dati ad alta velocità su lunghe distanze, gestendo quasi tutto il traffico commerciale e delle comunicazioni del mondo tramite luce anziché elettricità. Sebbene i data center utilizzino la fibra ottica per le loro reti di comunicazione esterne, i rack continuano ad utilizzare principalmente cavi elettrici in rame per le comunicazioni interne. Questi cavi collegano gli acceleratori di Gpu, i quali possono rimanere inattivi per più della metà del loro ciclo di vita in attesa di ricevere i dati durante l’addestramento dei modelli distribuito su larga scala, comportando spese e consumi di energia significativi.

La nuova frontiera: connettività ottica nei data center

I ricercatori Ibm hanno dimostrato un modo per portare la velocità e la capacità dell’ottica all’interno dei data center. In un articolo scientifico, appena pubblicato in versione preliminare su arXiv, Ibm presenta un nuovo prototipo di un modulo Cpo in grado di abilitare la connettività ottica ad alta velocità. Questa tecnologia potrebbe aumentare in modo significativo la larghezza di banda delle comunicazioni dei data center, riducendo al minimo i tempi di inattività delle Gpu e accelerando drasticamente i processi di AI. Questa innovazione nel campo della ricerca, come descritto nell’articolo, consentirebbe di ridurre i costi per scalare l’AI generativa grazie a una diminuzione del consumo energetico di oltre 5 volte rispetto alle interconnessioni elettriche di fascia media, estendendo al contempo la lunghezza dei cavi di interconnessione dei data center da un metro a centinaia di metri; addestrare più rapidamente i modelli di AI, consentendo agli sviluppatori di creare un Large Language Model (Llm) fino a cinque volte più velocemente con la Cpo rispetto a quanto sarebbe possibile con il cablaggio elettrico convenzionale. La Cpo potrebbe ridurre il tempo necessario per addestrare un Llm standard da tre mesi a tre settimane, con un aumento delle prestazioni grazie all’utilizzo di modelli più grandi e di un maggior numero di Gpu; aumentare drasticamente l’efficienza energetica dei data center, con un risparmio energetico equivalente al consumo annuo di 5.000 abitazioni statunitensi per ogni modello di AI addestrato.

Verso una nuova era di comunicazioni

“Poiché l’AI generativa richiede più energia e potenza di elaborazione, il data center deve evolversi e l’ottica co-packaged può rendere questi data center adatti alle esigenze future”, ha…